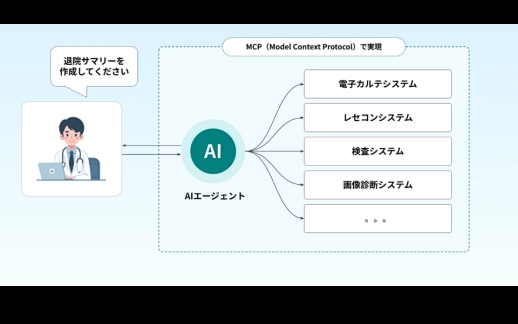

AIエージェント

医療特化型AIエージェント導入 Vol.4:AIエージェントの判断をどう説明するか 医療に不可欠な「説明可能性」という壁

近年、医療・ヘルスケア分野でも生成AIやAIエージェントの導入検討が急速に進んでいます。しかし一方で、「AIを導入したいが、臨床現場で本当に使えるのか」「安全性や説明責任をどう確保するのか」といった懸念の声も少なくありません。本記事では、医療特化型AIエージェントの導入にあたって特に重要となるリスクと、それを克服するための最新アプローチについて解説いたします。

医療AI導入に潜むリスク

医療の現場にAIを導入する際には、いくつかの根本的な課題が存在します。とりわけ「ブラックボックス問題」「ハルシネーション(幻覚生成)」「データ標準化の未整備」は大きなリスクとして認識されています。以下、それぞれの内容について詳しく見ていきましょう。

ブラックボックス問題と説明責任

AI、とりわけディープラーニングや大規模言語モデル(LLM)は、数百万〜数十億のパラメータを持つ非線形モデルであり、その推論過程は人間にとって理解が難しい「ブラックボックス」となっています。

医療の現場では、「なぜその診断や治療方針を導き出したのか」を説明できなければ、医師も患者も安心して活用することはできません。こうした背景から、Explainable AI(説明可能なAI: XAI) への注目が高まっています。

ハルシネーション(幻覚生成)のリスク

LLMを活用するAIエージェントは、正しいように見えるが実際には誤った情報を生成する「ハルシネーション」のリスクを常に抱えています。

例えば、医療音声記録の自動転記ツールが「存在しない薬剤名」を生成したり、意味不明な語句を含んでしまうケースが報告されています。これが臨床判断に組み込まれると、誤診や不適切な治療につながる恐れがあるのです。

データ標準化の未整備

さらに、医療データは病院ごとに形式や表記揺れが多く、標準化や構造化が十分に進んでいません。ソースの信頼性確認も容易ではなく、AIモデルにそのまま入力すれば誤学習のリスクが高まります。こうした課題を解消しなければ、安全かつ実用的なAIエージェント導入は困難です。

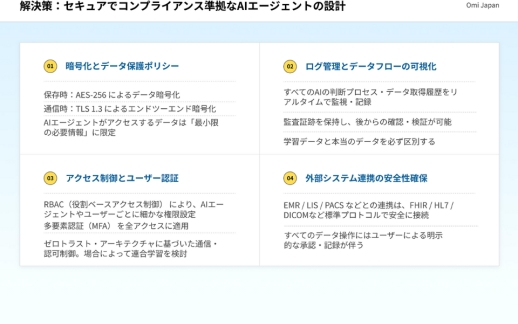

解決策:信頼性と透明性を両立させるアプローチ

上記のようなリスクを克服するためには、AIの設計思想そのものを工夫する必要があります。ここでは現在注目されている代表的な解決策として「RAG」「ファインチューニング」「Chain-of-Thought」「モデル非依存型の説明手法」、そして「Human-in-the-Loop」の5つをご紹介します。

RAG(Retrieval-Augmented Generation)の活用

現在注目されているのが RAGアーキテクチャ です。

RAGは、LLMに外部の信頼できる知識を参照させることで、より正確かつ根拠のある回答を生成する仕組みです。

- 通常のAI:学習済みデータのみをもとに推論

- RAG:外部データベース(論文、ガイドラインなど)をリアルタイムで検索・統合

この仕組みによって、AIの回答に「根拠」が伴うため、臨床現場での安心感が大幅に高まります。さらに、この外部知識は オントロジー や ナレッジグラフ といった構造で管理されることが多く、医学的な一貫性と検索性を担保できます。

専門データによるファインチューニング

医師監修済みの専門的な医療データを用いてLLMをファインチューニングすることで、

- 医学用語の理解精度向上

- 文脈把握の正確性向上

といった効果が得られます。汎用的な学習データだけでは補えない「医療特化型」の精度向上に不可欠な取り組みです。

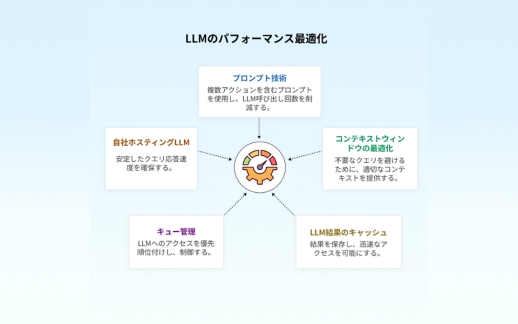

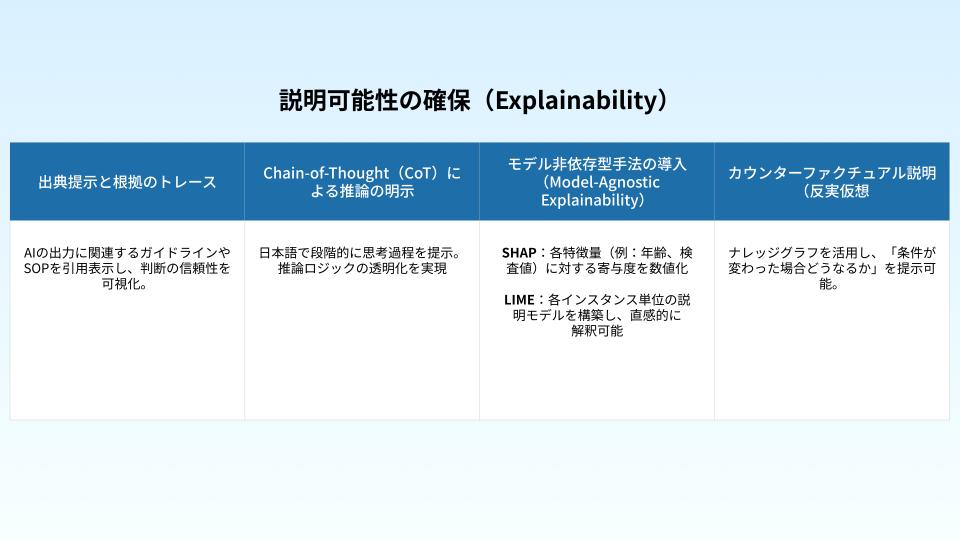

Chain-of-Thought(CoT)による推論プロセスの可視化

プロンプトエンジニアリングを駆使し、AIに推論の過程を段階的に説明させることで「なぜその結論に至ったか」を可視化します。これにより、医療従事者がAIの出力を批判的に検証できるようになります。

モデル非依存型手法の導入

SHAPやLIMEといった、モデル構造に依存しない説明手法を組み合わせることで、誰でも理解しやすい形でAIの意思決定を“見える化”できます。これはXAIの実装において非常に有効です。

- SHAP:各特徴量(例:年齢、検査値)に対する寄与度を数値化

- LIME:各インスタンス単位の説明モデルを構築し、直感的に解釈可能

Human-in-the-Loop(人間の関与)の前提

どれほど高度なAIであっても、医療の最終判断は人間が担うべきです。そのためには、

- 医師や医療スタッフが安心して利用できるUI/UX設計

- 重要局面で必ず人間が介入できるワークフロー

の整備が欠かせません。AIはあくまで支援ツールであり、医師の判断を補強する存在であるべきなのです。

導入に向けたステップと展望

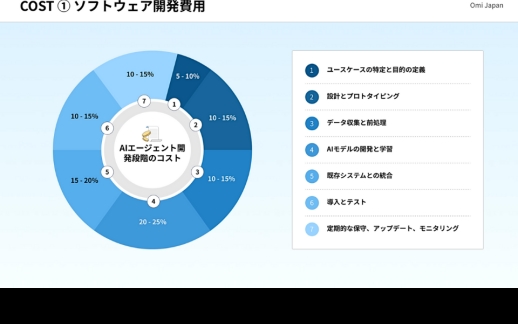

解決策が見えてきたとはいえ、実際に導入するには段階的なアプローチが重要です。ここでは、医療特化型AIエージェントを導入する際に推奨されるプロセスを整理します。

- PoC(概念実証)から開始

小規模な業務フローに組み込み、精度や運用性を検証する。 - データ基盤の整備

標準化・構造化を進め、AIに適したデータ環境を構築。 - XAI・RAG・CoTの組み合わせ

信頼性と透明性を担保するアーキテクチャを実装。 - 現場の医療従事者を巻き込む

トレーニングやUI設計段階から参加させることで、現場適合性を高める。

こうしたステップを踏むことで、AIエージェントが「実際に現場で使える技術」として根付いていきます。

まとめ:信頼できるAI導入の第一歩へ

医療特化型AIエージェントの導入は、単に技術的な課題を解決するだけでなく、「現場で安心して使える仕組み」をいかに設計するかがカギとなります。

ハルシネーションやブラックボックス問題といったリスクは存在しますが、RAGやXAI、専門データによるファインチューニング、そしてHuman-in-the-Loopを組み合わせることで、十分に克服可能です。

最後ですが、Omi Japanでは、これまで350件以上の医療システム開発実績と、AIエージェントを活用した医療DXプロジェクト支援の経験を活かし、「医療特化型AIエージェントPoCキャンペーン」をご提供しています。最短2ヶ月・399万円から、御社の業務フローに合わせてカスタマイズされたPoC構築が可能です。